'PR-242: BERT4Rec -Sequential Recommendation with BERT - YouTube'를 보고 작성한 글입니다. 😀

Research Trends

Interaction-only setting

Use user-item interaction(feedback) matrix only

feedback 데이터는 Implicit Data (조회 및 클릭 여부)와 Explicit Data (평점 데이터)로 나뉜다.

[출처]

보통 Implicit Data와 Explicit Data 모두 고차원의 Sparse한 user-item matrix이기 때문에 이를 저차원의 user matrix와 item matrix로 분해하여 두 matrix의 곱으로 원래의 user-item matrix와 가장 유사하게 학습하는 모델이 Matrix Factorization(MF)이다.

Traditional Models

- Alternative Least Square Matrix Factorization (ALS)

- Bayesian Personalized Ranking (BPR)

- Collaborative Metric Learning (CML)

- Factorization Machine (FM)

Nonlinear transformations with deep neural networks

- Neural Collaborative Filtering (NCF) : MF + MLP

Representation Learning

Neural Collaborative Filtering (NCF) : MF + MLP

Matrix Factorization

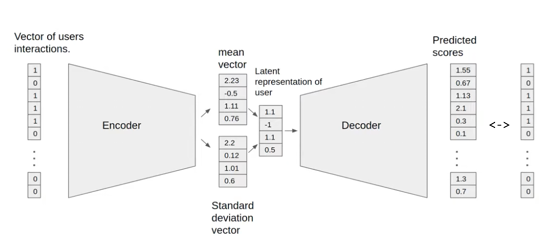

Variational Autoencoders for Collaborative Filtering (VAE-CF)

[[출처](Liang, Dawen, et al. "Variational autoencoders for collaborative filtering." Proceedings of the 2018 World Wide Web Conference. 2018.)]

The limit of Interaction model

유저가 아이템을 어떠한 순서대로 소비했는지, 최근에 소비한 아이템이 무엇인지 알 수 없다.

즉, 단지 아이템을 소비한 여부만 알 수 있다.

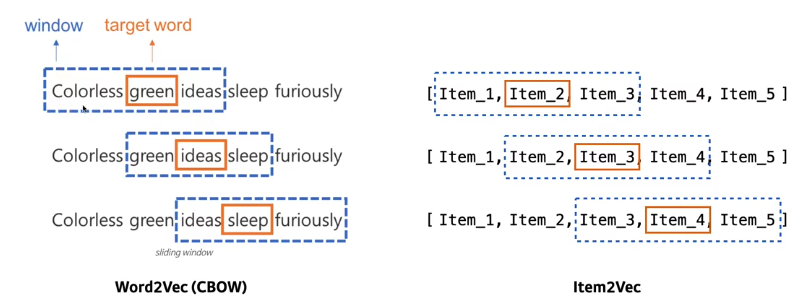

Word2Vec -> Item2Vec

[[출처](Barkan, Oren, and Noam Koenigstein. "Item2vec: neural item embedding for collaborative filtering." 2016 IEEE 26th International Workshop on Machine Learning for Signal Processing (MLSP). IEEE, 2016.)]

Word2Vec(CBOW)는 주변 단어를 학습하여 가운데 단어(target word)를 예측한다.

Item2Vec 역시 주변 아이템을 학습하여 가운데 아이템을 예측한다.

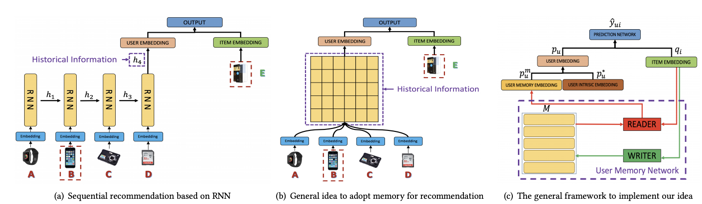

Sequential Recommendation

Traditional models ignore the order in user's behaviors

RNN, Transformer are good for modeling sequential behaviors

([출처]((Chen, Xu, et al. "Sequential recommendation with user memory networks." Proceedings of the eleventh ACM international conference on web search and data mining. 2018.)))

sequential model에서 RNN 보다 Transformer가 더 좋은 성능을 보여주기 때문에 Transformer를 이용한 Sequential Recommendation도 제안되었다.

Consider item as token, user behavior as sequence of tokens

- 토큰 대신에 아이템을 넣고, 문장 대신에 유저의 behavior를 하나의 sequence로 넣는다.

- Word2Vec -> Prod2Vec

Datasets

Amazon Beauty : Series of product review datasets

Stream dataset : Video game reviews

MovieLens : Movie reviews

위 표에서 Density는 유저 아이템의 수에 비해 interaction이 얼마나 많은지를 나타내는 값이다. 즉, Density가 작을수록 유저와 아이템에 비해 소비된 아이템이 적다라고 볼 수 있다.

Task Setting & Evaluations

Task Setting : leave one-out-evalutaion

- For each user, leave the last item of the behavior sequence as test data

- To calculate hit rate, randomly sample 100 negative items according to their popularity

Evaluations

- Hit@k

- NDCG@k

Baseline Models

POP : 전체 아이템들을 인기도가 높은 순서대로 추천 (TOP K)

BPR-MF : Interaction matrix를 분해하여 positive/negative feedback에 pairwise ranking loss 사용

NCF : MF기반에 dot product대신 MLP로 학습

GRU4Rec : 시퀀스를 GRU에 넣어 학습

SASRec : Transformer를 바탕으로 학습

BERT4Rec

Original BERT is not for language model

BERT는 맨 마지막 단어를 예측하는 것이 아닌 중간의 Masking한 토큰을 학습한다.

따라서, 전체 Sequence를 학습하는 것은 적합하지만 Sequential recommendation처럼 다음 아이템을 예측하는 것은 적합하지 않다.

Appned <Mask> token to end of sequence to predict the last item

BERT를 Language Model에 적합하게 하기 위해 마지에 <Mask> token을 붙여 마지막 아이템을 예측하도록 하게 한다.

Use Masked Language Model objective only

Removed next sentence loss, segment embeddings

추천에서는 단락이라는 개념이 없다. 즉, 유저의 item 소비 순서는 서로 전혀 연관이 없기 때문에 next sentence loss, segment embeddings를 제거한다.

BERT와 달리 BERT4Rec는 순차적 추천 작업에서 사용자의 과거 행동을 하나의 시퀀스로만 모델링하므로 sentence loss, segment embeddings을 제거한다.

Results

Restrictions

Assumptions

Items and users are changing envery second

이 논문에서 사용하는 데이터셋은 대부분 아이템, 유저가 정해져 있다.

그러나 실제 추천시스템에선 아이템, 유저의 수가 정해져있지 않다.

매초마다 새로운 token이 추가되고 삭제되는 등 item이 계속 바뀌고 유저도 계속 유입/이탈됩니다.

Sequence of items are not always ordered

Items have lifespan not like tokens in NLP

Domain에 따른 item의 lifespan이 다르다.

뉴스를 보면 하루 전의 것을 추천하지 않고 시간 별로 추천뉴스 달라진다는 특징을 예로 들 수 있다.

Practical restrictions

- Fast inference is more important than model score

- 추천시스템의 경우 모델의 성능 보다 Fast inference(학습 속도)가 더 중요하다.

- Do offline evaluations correlate with online results? (Exposure bias)

- 즉, Offline evaluation이 online result와 다른 경우가 많다.

References

- PR-242: BERT4Rec -Sequential Recommendation with BERT - YouTube

- [논문 리뷰] BERT4Rec: Sequential Recommendation with Bidirectional Encoder Representations from Transformer

🏋🏻 개인적으로 공부한 내용을 기록하고 있습니다.

잘못된 부분이 있다면 과감하게 지적해주세요!! 🏋'추천 시스템 > Paper' 카테고리의 다른 글

| [논문 리뷰] Transformer : Attention Is All You Need (NIPS 2017) (0) | 2021.11.24 |

|---|---|

| [논문 리뷰] Factorization Machines (0) | 2021.11.24 |

| [논문 리뷰] Next Item Recommendation with Self-Attentive Metric Learning (0) | 2021.11.24 |

댓글